Apple lleva la computación espacial a iOS

Eduard Rosicart

- 14 septiembre, 2023

Apple estrena nuevas funciones inmersivas para los próximos modelos iPhone 15 Pro, ya que la empresa planea una profunda polinización cruzada en todo su ecosistema de dispositivos

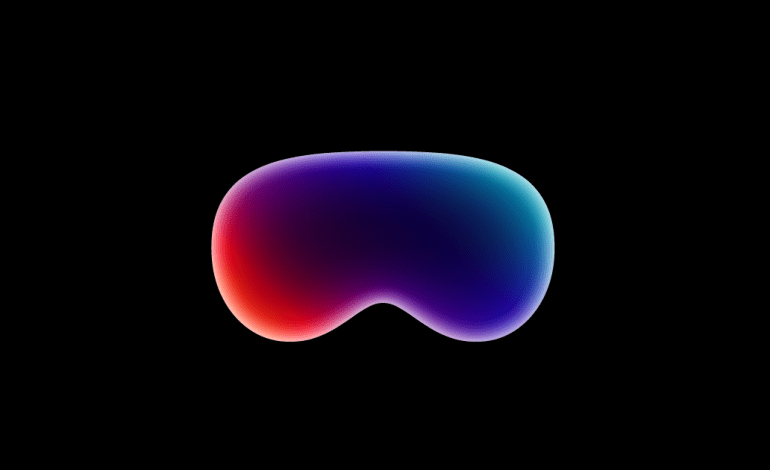

Apple se está preparando para el debut de las Vision Pro. El primer casco Realidad Extendida de la empresa llegará pronto, y con él viene una ambición de computación espacial que presenta similitudes y diferencias con Lenovo, Microsoft, Meta, HTC VIVE y otros vendedores de cascos Realidad Extendida.

Sin embargo, una diferencia y ventaja clave que Apple tiene sobre algunos de sus competidores es el ecosistema iOS ya establecido de productos y software. En su presentación inicial de las gafas Vision Pro, Apple destacó cómo los operadores de auriculares pueden aprovechar el marco de computación espacial Vision Pro junto con otros productos y servicios de origen propio, desde aplicaciones para el lugar de trabajo hasta hardware como el Apple TV.

Si Apple aprovecha con éxito su ecosistema de productos junto con sus nuevos auriculares MR, la empresa podría encontrarse en una posición única para ofrecer un dispositivo inmersivo con una línea de software y hardware compatible y familiar -que los usuarios ya pueden poseer- lista para el lanzamiento, que podría impulsar las tasas de usabilidad y adopción.

Además, Apple también está impulsando su SDK Vision Pro para que sea compatible con sus aplicaciones inmersivas de origen y de terceros compatibles con Unity, de nuevo en un intento de crear una sofisticada pieza de hardware con una línea de aplicaciones y hardware integrados lista para su lanzamiento.

Por otra parte, Apple no es la única empresa de Realidad Extendida que está impulsando la interoperabilidad y la polinización cruzada de hardware y software. Por ejemplo, Microsoft se está preparando para una hoja de ruta Metaverso industrial para 2024, en la que la empresa trabajará con grupos como Magic Leap y Qualcomm para ofrecer soluciones de inmersión en el lugar de trabajo que funcionen junto a pilas tecnológicas preexistentes.

Además, muchas empresas alternativas de Realidad Aumentada, como Xreal, están aprovechando el hardware de Android e iPhone para impulsar visiones separadas de computación espacial, permitiendo así que una amplia gama de usuarios de hardware adopten una oferta de productos de Realidad Aumentada mucho más barata. En particular, Xreal presentó a principios de este año el Spacetop, un portátil de computación espacial sin pantalla que funciona con las gafas de Realidad Aumentada de Xreal. Permite a los usuarios interactuar con la pantalla virtual de varias formas, como utilizar gestos de la mano para controlar el cursor o la voz para dictar órdenes, algo muy similar a lo que prometía Vision Pro.

Aunque los observadores no se dieron cuenta en su momento, el Xreal/Sightful Spacetop es increíblemente similar a las Vision Pro de Apple y a la hoja de ruta de la computación espacial. Apenas unos días después del anuncio del Sapetop, Apple reveló su producto Vision Pro.

Ambas empresas esperan que las soluciones de productividad espacial lideren el mercado de la Realidad Extendida, y Xreal afirma que esta vía proporcionará el “primer caso de uso 100M Realidad Aumentada killer” del mundo, lo que significa que las soluciones de computación espacial que sustituyan a los portátiles podrían ser el primer caso de uso de la RA que consiga una base de usuarios de 100 millones de personas. Además, lo más probable es que Apple esté de acuerdo en que su propia visión de la computación espacial transformará las tasas de adopción de los consumidores.

Las ventajas de la interoperabilidad y la polinización cruzada de la Realidad Extendida

Está claro que la competencia es grande. Desde empresas líderes en productividad digital como Microsoft hasta actores más recientes como Xreal, Apple tendrá que trabajar duro durante los próximos 12 meses para persuadir al público en general y a los fanáticos acérrimos de la Realidad Extendida de que la infraestructura inmersiva de iOS es el siguiente paso para impulsar la productividad y revolucionar la forma en que el mundo interactúa con la información digital.

Para liderar la carrera espacial inmersiva, Apple está integrando de forma inteligente y gradual funciones de computación espacial en el ecosistema iOS.

Los productos iPhone e iPad de Apple ya incorporan muchas funciones de Realidad Aumentada. Cada vez más, los teléfonos inteligentes son la forma más habitual en que el público, tanto consumidor como profesional, interactúa con la Realidad Extendida.

Desde colocar filtros de Realidad Aumentada en Instagram hasta colocar gemelos digitales de alta calidad en una obra de construcción, las cámaras de los smartphones son increíblemente sofisticadas y permiten a los usuarios finales aprovechar la Realidad Extendida hoy en día.

Sin embargo, en comparación con los auriculares, la integración inmersiva de los teléfonos inteligentes presenta retos desde el punto de vista del desarrollo y la usabilidad. Un problema notable son las funciones de apagado automático del teléfono, que suelen crear obstáculos para los servicios de colocación de Realidad Aumentada.

Por otro lado, Las gafas de Realidad Extendida pueden superar las deficiencias de los teléfonos inteligentes gracias a las funciones de inmersión específicas de las gafas de Realidad Extendida. La combinación de smartphones preexistentes preparados para la Realidad Extendida con unas gafas inmersivas podría mejorar significativamente los casos de uso actuales de la Realidad Extendida.

¡La Realidad Extendida llega a iOS!

Apple es consciente de las ventajas de la polinización cruzada y la interoperabilidad de los dispositivos. Recientemente, la empresa presentó una serie de funciones inmersivas para su último producto iPhone, en línea con la hoja de ruta más completa de las Vision Pro.

A principios de este mes, Apple presentó sus planes de estrenar una nueva App Store para las Vision Pro que distribuya servicios y juegos para las gafas de RM de próxima aparición. La nueva tienda incluirá “cientos de miles de aplicaciones para iPad y iPhone” que funcionarán con el sistema operativo Vision Pro (visionOS).

Esta medida permite que las aplicaciones preexistentes y las nuevas para iPhone y iPad funcionen en el dispositivo Vision Pro. Durante su evento de presentación de la WWDC, Apple ya destacó cómo los usuarios podían aprovechar las aplicaciones clásicas de productividad de primera mano en el dispositivo Vision Pro.

Ahora, con la tienda de aplicaciones Vision Pro App Store y la disponibilidad general del SDK del dispositivo para desarrolladores, Apple está abriendo su próximo auricular MR a un sinfín de servicios de venta de sistemas listos para su debut en 2024, que abarcan diversos casos de uso, desde los juegos a las comunicaciones, pasando por la productividad y el entretenimiento.

Además, Apple señala que la polinización cruzada de las aplicaciones de iOS con las Vision Pro permite que “la mayoría de los servicios de iPad e iPhone” funcionen en las Vision Pro. Por tanto, los desarrolladores pueden ampliar el alcance de audiencia de una aplicación “sin necesidad de trabajo adicional”.

Por defecto, Apple publicará automáticamente las aplicaciones para iPhone y iPad en la App Store de Vison Pro, lo que aumentará significativamente el número de casos de uso del producto de forma instantánea.

En un comunicado oficial, Apple dijo

La mayoría de los frameworks disponibles en iPadOS e iOS también están incluidos en visionOS, lo que significa que casi todas las aplicaciones para iPad e iPhone pueden ejecutarse en visionOS, sin modificaciones. Los clientes podrán utilizar sus apps en visionOS a principios del año que viene, cuando Apple Vision Pro esté disponible.

Las Vision Pro App Store llegarán este otoño, dice Apple. La empresa también está trabajando en una próxima versión beta de visionOS que incluirá la App Store; esto debería resultar próspero, ya que los desarrolladores ya están teniendo un gran éxito con el marco SDK disponible.

A pesar de los avances en la portabilidad de servicios iOS a visionOS, Apple afirma que portar una aplicación 2D al SDK de computación espacial de las Vision Pro no es sencillo ni fácil. Sin embargo, Apple está dando soporte a las aplicaciones que puedan tener problemas.

A través de App Store Connect, Apple notificará a los desarrolladores si su aplicación es incompatible y no estará disponible en las Vision Pro. Si una aplicación iOS requiere una capacidad no disponible en Apple Vision Pro, Apple ayudará a los desarrolladores a proporcionar una funcionalidad alternativa o actualizaciones de las UIRequireDeviceCapabilities de un servicio para adaptarse a visionOS.

Además, en un reciente post de Apple, Chris Flick, ingeniero de Apple AVFoundation, afirmó que Apple está “apoyando un nuevo paradigma de experiencias espaciales”.

Flick también añadió

Hemos hecho que sea lo más fácil posible llevar tu contenido 2D existente a una experiencia espacial. Con algunas pequeñas modificaciones en tu canal 2D actual, puedes soportar contenido 3D utilizando MV-HEVC. Incluso puedes seguir utilizando todos tus subtítulos existentes de activos 2D. Pero si proporcionas metadatos cronometrados, esos subtítulos pueden no estar oscurecidos y proporcionar una experiencia de visualización cómoda.

Los desarrolladores también pueden probar si una aplicación es compatible con las Vision Pro mediante un simulador visionOS disponible en la beta de Xcode 15, que permite a los desarrolladores probar “fácilmente” las funcionalidades básicas de un servicio en un entorno de computación espacial. Para acceder a este servicio de pruebas, los desarrolladores deben enviar una aplicación iOS para que se evalúe su compatibilidad o inscribirse en el laboratorio de desarrolladores de Apple.

¡La grabación espacial llega a iOS!

En otras noticias, Apple ha publicado recientemente actualizaciones relativas a su próximo iPhone 15 Pro. En su presentación de principios de semana, la empresa presentó una serie de nuevas funciones para vender al público la última iteración del smartphone.

En cuanto a la Realidad Extendida, Apple introduce la grabación de vídeo espacial para el último modelo de iPhone. Esta función permite a los propietarios de dispositivos crear capturas de momentos en 3D, lo que permite a los operadores de las Vision Pro reproducir las secuencias y verlas como una visualización RT3D MR, que puede verse desde varios ángulos.

La transmisión multimedia espacial llegará a los teléfonos inteligentes de Apple el año que viene, lo que mejorará significativamente las capacidades de Realidad Extendida de la cartera de productos respecto a sus inicios de Realidad Aumentada y preparará a la enorme base de usuarios para el debut de las Vision Pro 2024, con la esperanza de convencer a los propietarios de teléfonos inteligentes para que compren el nuevo producto de Apple.

La noticia llega cuando Apple parece tener previsto integrar las funciones de Realidad Extendida en otras áreas de su cartera de productos.

En agosto, Ming-Chi Kuo, analista de confianza de Apple, señaló que el próximo producto AirTag 2 podría incluir funciones de seguimiento inmersivo. Kuo dijo que el dispositivo de seguimiento actualizado debutará en el cuarto trimestre de 2024, y que la compatibilidad con las Vision Pro llegará con su lanzamiento.

Kuo también cree que la computación espacial es “un nuevo ecosistema que Apple quiere construir, utilizando las Vision Pro como núcleo para integrar otros dispositivos, incluido el AirTag 2”.

En 2023, surgieron informes que destacaban cómo el código de la versión 13 de iOS sugiere que los usuarios pronto podrán encontrar AirTags mediante visualizaciones de Realidad Aumentada.

AirTag 2 con funciones de localización de Realidad Aumentada podría integrarse fácilmente en el marco de trabajo de las Vision Pro MR. Sin embargo, las funciones Realidad Aumentada de AirTag podrían funcionar en tándem con los dispositivos iPhone de Apple, ya que los iPhones modernos vienen con cámaras que admiten visualizaciones Realidad Aumentada, lo que quizá signifique que los usuarios de iPhone podrán encontrar sus dispositivos AirTag 2 mediante visualizaciones Realidad Aumentada a través de la cámara del dispositivo, que ahora estará mejorada con capacidades de grabación espacial.

Además, informes recientes muestran que Apple está desarrollando un parabrisas de Realidad Aumentada, ¡un producto conceptual en el que la empresa empezó a trabajar en 2015!

Según la solicitud de patente, Apple aprovechará sensores como cámaras de infrarrojos, LiDAR y cámaras tradicionales para permitir visualizaciones de Realidad Aumentada que mejoren el uso del vehículo y las funciones de seguridad.

Según la patente, la solución de conducción de Realidad Aumentada de Apple podría mostrar datos como badenes y también estabilizar el rendimiento de la conducción comunicándose con el vehículo o mostrando restricciones de conducción como zonas escolares para alertar a los conductores de los límites de velocidad. Además, las opciones adicionales de passthrough podrían proporcionar vistas de señales de tráfico ocultas tras objetos.

Experiencia de primera mano de los desarrolladores y portabilidad de aplicaciones iOS a la Realidad Extendida, hoy mismo

Los desarrolladores ya están teniendo un gran éxito con el SDK de visionOS. El mes pasado, Apple publicó una serie de experiencias curadas para desarrolladores en las que se destacaban las ventajas del SDK y se trabajaba desde uno de los Developer Labs de Apple, un espacio para aprovechar el hardware, el software y los recursos de la empresa para crear aplicaciones en todo el ecosistema del SO de Apple. Estos espacios también permiten a los desarrolladores probar y optimizar aplicaciones inmersivas para visionOS, al tiempo que animan a los desarrolladores de Realidad Extendida a crear contenidos bajo la dirección de Apple, lo que contribuye a aumentar el talento de los desarrolladores y la innovación.

Por ejemplo, Michael Simmons, consejero delegado de Flexibits, dijo que la experiencia de trabajar en un Apple Lab por primera vez fue “fantástica. Me sentí como si formara parte de la aplicación”.

Simmons trabajó en un laboratorio con sede en Cupertino, que describieron como un “campo de pruebas” para las innovaciones y el crecimiento de las aplicaciones inmersivas. Además, señaló cómo el laboratorio proporciona un espacio para que los desarrolladores de Realidad Extendida lleven todo el ecosistema del SO de Apple más allá de sus limitaciones. En combinación con el dispositivo Vision Pro, los creadores de Realidad Extendida que trabajan desde el Laboratorio de Desarrolladores pueden experimentar de primera mano la marca de Apple de computación espacial, ampliando sus conocimientos de RA/RM/VR.

explicó Simmons:

Una pantalla con bordes puede ser limitante. Claro, puedes desplazarte o tener varios monitores, pero en general, estás limitado a los bordes. Experimentar la informática espacial no sólo validó los diseños en los que habíamos estado pensando, sino que nos ayudó a empezar a pensar no sólo de izquierda a derecha o de arriba abajo, sino más allá de los bordes en absoluto.

Otro desarrollador de la Realidad Extendida, David Smith, señaló cómo el Apple Lab que visitó “tachó todo de mi lista”. El desarrollador explicó cómo trabajar con Apple Vision Pro y la computación espacial de primera mano ayudó a Smith a comprender cómo desarrollar para el “lienzo ilimitado” que proporciona el visionOS, destacando cómo el espacio de aprendizaje permitió a Smith “dejar de pensar en lo que cabe en una pantalla” y, por tanto, ayudándose a sí mismo y a otros a “hacer mejores apps”.

Smith también dio detalles sobre la función de prueba in situ del visonOS, añadiendo: “Llevaba semanas mirando esta cosa en el simulador y haciéndome una idea general de cómo funciona, pero eso era en una caja. La primera vez que ves tu propia aplicación funcionando de verdad, es cuando oyes un grito ahogado”. El experimentado desarrollador observó cómo un visitante del laboratorio de Apple podía empezar a entender preguntas que sólo pueden responderse cuando un desarrollador trabaja con un dispositivo Vison Pro.

Smith también señaló

No es necesariamente que haya resuelto todos los problemas, pero he resuelto los suficientes como para hacerme una idea del tipo de soluciones que probablemente necesitaría. Ahora hay un cambio radical en mi capacidad para desarrollar en el simulador, escribir código de calidad y diseñar buenas experiencias de usuario.

El Director de Experiencia de Spool, Ben Guerrette, señaló cómo su equipo aprovechó el laboratorio de Realidad Extendida de Apple para explorar nuevas interacciones espaciales para su aplicación de smartphone, explicando cómo el laboratorio ayudó a su empresa a llevar su juego basado en pantalla a un entorno RT3D, añadiendo cómo la instalación proporciona una experiencia de aprendizaje “increíblemente valiosa” que “nos da la oportunidad de decir: ‘Vale, ahora entendemos con qué estamos trabajando, cuál es la interacción y cómo podemos hacer una conexión más fuerte”, remarcó Guerrette.

Por último, Chris Delbuck, tecnólogo principal de diseño en Slack, explicó cómo los laboratorios permiten a los desarrolladores ponerse manos a la obra con el dispositivo Apple Vision Pro, lo que permite a los desarrolladores comprender el potencial de la Realidad Extendida y la computación espacial. “Me hizo pensar al instante en cómo las ofertas y los efectos visuales en 3D podrían aparecer en nuestras experiencias”, añadió Delbuck.

Los servicios de nivel empresarial llegan a las Vision Pro

Los comentarios curados llegan cuando los proveedores de soluciones de nivel empresarial están aprovechando el SDK disponible para preparar soluciones de productividad para el debut de Vision Pro en 2024.

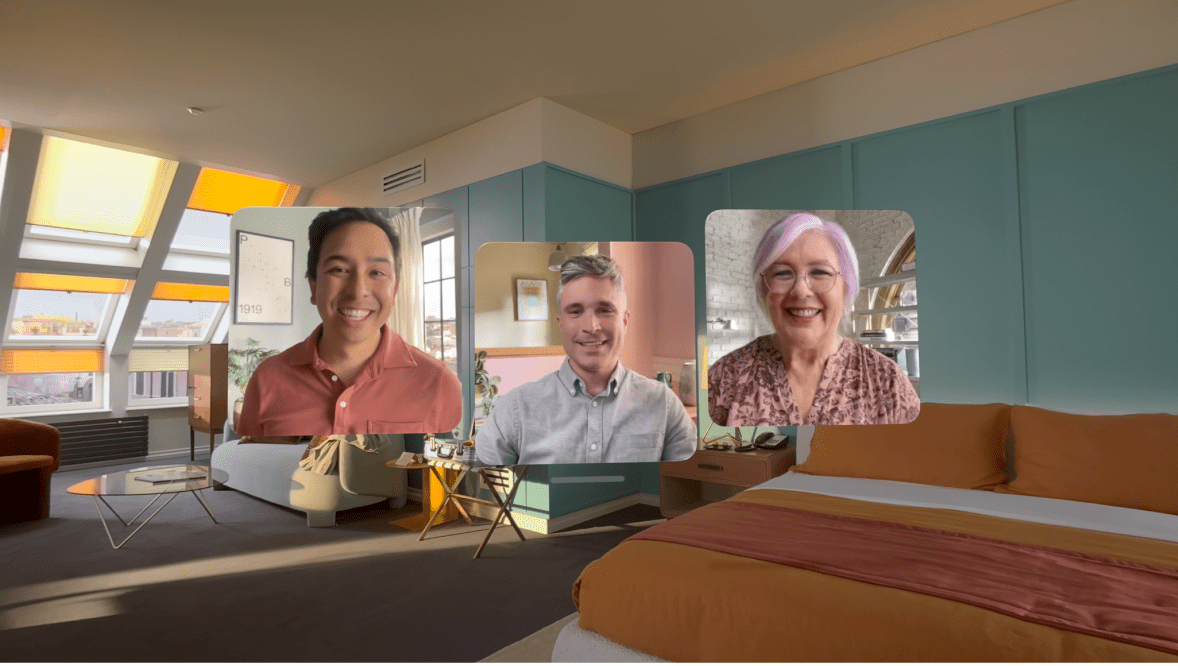

El proveedor de soluciones de comunicaciones unificadas (CU) Wildix está llevando aplicaciones empresariales de RM a Vision Pro, empezando por el debut de sus estimadas soluciones digitales para el lugar de trabajo en las gafas Realidad Extendida de Apple.

Dimitri Osler, Fundador y Director Técnico de Wildix, explicó:

Esto demuestra lo eficaz que puede ser el desarrollo dentro de pequeños equipos dedicados a este fin. Al igual que con WebRTC, vemos el potencial de esta tecnología, y estamos orgullosos de ser los primeros en haberla creado.

Wildix está portando su software UC a las gafas de próxima aparición, lo que permitirá a los usuarios de las Vision Pro acceder a las funciones de reunión, chat de texto y llamada telefónica dentro del sistema operativo de computación espacial.

El servicio UC inmersivo también permite a los usuarios de las Vision Pro acceder a las funciones de la marca Wildix en salas de reuniones virtuales totalmente desarrolladas, accesibles para usuarios de todo el mundo que deseen conectarse y colaborar.

Muchos otros servicios inmersivos, como la aplicación Metaverse Rec Room, están llegando a las Vision Pro, y a medida que se acerque la ventana de lanzamiento de Apple, seguramente llegarán más aplicaciones al dispositivo.

Más sobre Apple Vision Pro

Mientras que algunas audiencias se muestran escépticas sobre la costosa entrada de Apple en el mercado, los competidores reconocen el potencial de Apple. A principios de este mes, algunos informes destacaban cómo Google y Samsung se enfrentan a un “gran temor” cuando Apple lanza nuevos productos.

Las Vision Pro saldrán a la venta en 2024 por 3.499 dólares. Las gafas Vision Pro de Apple se distinguen por un enfoque de tres capas para garantizar a los usuarios una interfaz de computación espacial accesible, fácil de usar y flexible.

- Ventanas que representan la interfaz de usuario 2D del dispositivo.

- Volúmenes que proporcionan experiencias inmersivas RT3D.

- Los Espacios crean el entorno informático espacial en el que existen los Volúmenes y las aplicaciones MR.

Este enfoque de tres capas de las Vision Pro de Apple contiene características competitivas que potencian su estructura de computación espacial de tres niveles, como un chip de silicio M2 personalizado, el procesador gráfico R1 de Apple creado expresamente, una pantalla de 23 millones de píxeles a través de dos enormes lentes micro-OLED, salidas de alto rango dinámico (HDR) y amplia gama de colores (WCG), batería de 2 horas de duración, una cámara inmersiva para capturar audio/fotos/vídeo espaciales y compartirlos entre iguales, sincronización iPhone/iPad/Mac, un sello de luz, un escáner LiDAR y una cámara TrueDepth.

A pesar de los planes de crecimiento y difusión a través de sus espacios Lab, Apple se enfrenta a algunos obstáculos para comercializar los dispositivos Vision Pro.

En julio, algunos informes sugirieron que el socio de fabricación de Apple en el extranjero Luxshare Precision Industry Co. redujo su previsión inicial de ensamblaje de productos a 400.000 unidades, por debajo de la previsión de 1 millón de unidades de Apple y de la previsión interna de Luxhare de producir 18 millones de unidades anuales en los próximos años.

Dos de los socios fabricantes de componentes de Apple también redujeron las previsiones de producción a unas 130.000 a 150.000 unidades.

Según los informes de julio, Apple se enfrenta a la “complejidad” de la fabricación, lo que provoca “dificultades” en la producción derivadas de su micro-LED y su lente curva orientada hacia el exterior. La empresa también expresó su descontento con algunos de sus socios de producción,

La noticia se produjo a raíz de unos informes que destacaban cómo la producción del dispositivo Vision Pro de Apple sólo costará a sus fabricantes unos 1.590 dólares, mucho menos que el precio de mercado del dispositivo, que es de 3.499 dólares.