Las intersecciones de la Inteligencia Artificial y la Realidad Extendida

Angélica

- 18 agosto, 2023

Los titulares dicen que la inteligencia artificial es la nueva gran tecnología. ¿Hay sitio para todos?

Parece que fue ayer cuando se hablaba de Realidad Aumentada esto, Realidad Virtual aquello, metaverso, metaverso, metaverso. Ahora sólo se habla de inteligencia artificial. ¿Es una mala señal para la Realidad Extendida? Algunos parecen pensar que sí. Sin embargo, la gente del sector de la Realidad Extendida entiende que no es una competencia.

De hecho, la inteligencia artificial tiene un enorme papel que desempeñar en la construcción y la experiencia de los contenidos de Realidad Extendida, y forma parte de los debates metaversales de alto nivel desde hace mucho tiempo. Nunca he pretendido ser un experto en metaversos y no voy a pretender ser un experto en IA, así que he estado hablando con la gente que construye estas tecnologías para saber más sobre cómo se ayudan mutuamente.

Los tipos de Inteligencia Artificial en las Realidades Extendidas

A efectos de este artículo, hay tres ramas principales de la inteligencia artificial: la visión por ordenador, la IA generativa y los grandes modelos lingüísticos. La IA es más complicada que esto, pero nos ayudará a empezar a hablar de su relación con la Realidad Extendida.

Visión por ordenador

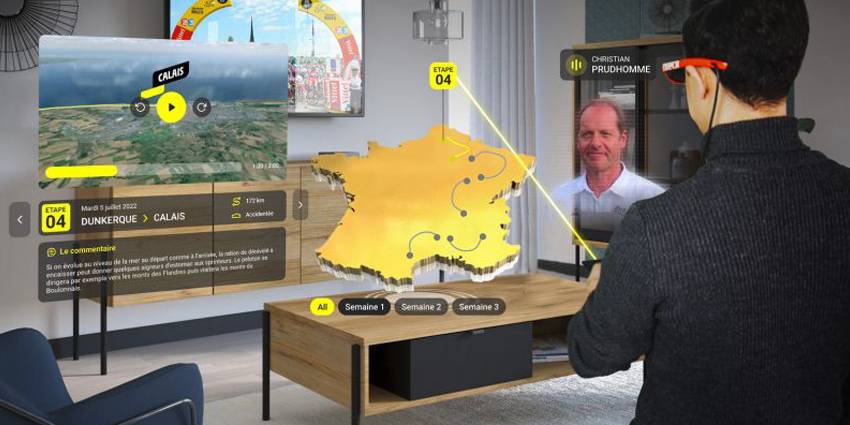

En la Realidad Extendida, la visión por ordenador ayuda a las aplicaciones a reconocer y comprender los elementos del entorno. Esto coloca elementos virtuales en el entorno y, a veces, les permite reaccionar ante ese entorno. La visión por ordenador también se utiliza cada vez más para agilizar la creación de gemelos digitales de objetos o lugares físicos.

Niantic es uno de los grandes constructores de mundos de la Realidad Extendida que utiliza la visión por ordenador y la comprensión de escenas para aumentar el realismo del mundo. 8th Wall, una adquisición que realiza sus propios proyectos pero que también sirve como división WebXR de Niantic, también utiliza algo de IA, pero también es compatible con otras herramientas de IA, como demostraron los equipos en un reciente hackathon del Laboratorio de Innovación.

“Durante el desafío de efectos de cielo en marzo, vimos algunas integraciones realmente interesantes de efectos de cielo con IA generativa, porque ese era el objeto brillante en ese momento”.

Dijo Caitlin Lacey, Directora Senior de Marketing de Producto de Niantic, a Metaverse News en una entrevista reciente. “Vimos cómo un proyecto tras otro daba ese giro y en realidad nunca lo vimos venir”.

El ganador utilizó IA generativa para crear el entorno que sustituyó al cielo mediante una herramienta reciente desarrollada por 8th Wall. Mientras que algunos consideran que la inteligencia artificial (ese “objeto brillante”) le quita el viento a las velas de la tecnología inmersiva, Lacey lo ve como una evolución más que como una distracción.

Lacey afirma:

“No creo que sea lo uno o lo otro. Creo que se complementan. Me gusta llamarlos la mantequilla de cacahuete y la mermelada de Internet”.

IA Generativa

La IA Generativa toma una indicación y la convierte en algún tipo de medio, ya sea una imagen, un vídeo corto o incluso un activo 3D. La IA generativa se utiliza a menudo en las experiencias de RV para crear “skyboxes”, la imagen plana sobre el paisaje virtual donde los jugadores tienen sus interacciones reales. Sin embargo, a medida que la IA se hace más fuerte, se utiliza cada vez más para crear activos y entornos virtuales propiamente dichos.

Inteligencia Artificial y creación profesional de contenidos

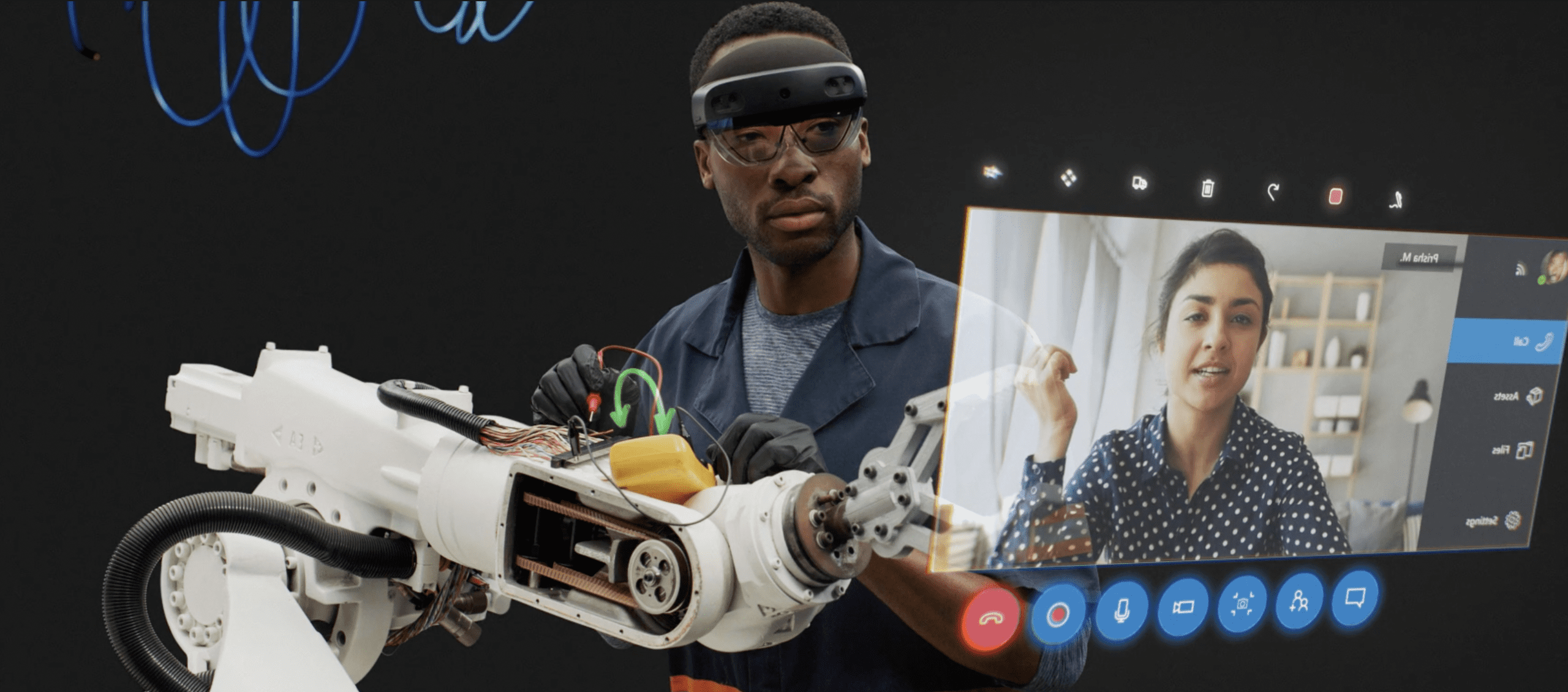

Talespin crea experiencias de Realidad Extendida inmersivas para la formación de habilidades sociales en el lugar de trabajo. La empresa lleva un tiempo utilizando la inteligencia artificial internamente, y recientemente ha puesto en marcha una herramienta de creación basada en la IA para sus clientes.

Un comunicado compartido con Metaverse News llama a la plataforma “un orquestador de varias tecnologías de IA entre bastidores”. Eso incluye el desarrollo de herramientas de IA generativa para la construcción de personajes y mundos, pero también incluye el trabajo con otros tipos de inteligencia artificial que exploraremos más a fondo en el artículo, como los LLM.

“Uno de los problemas que todos hemos tenido en la comunidad de la Realidad Extendida es que hay un contingente muy pequeño de personas que tienen el interés, los conocimientos y el tiempo para crear estas experiencias, por lo que esta enorme oportunidad se canaliza hacia un conducto muy estrecho”, dijo Kyle Jackson, director ejecutivo de Talespin, a Metaverse News. “Internamente, hemos visto una reducción del 95-97% en el tiempo de creación [con herramientas de IA]”.

Talespin no está introduciendo estas herramientas para quedarse fuera del negocio. Al contrario, Jackson dijo que su equipo puede implicarse aún más en ayudar a las empresas a crear sus experiencias porque su equipo pasa menos tiempo creando las experiencias por sí mismo. Jackson dijo además que éste es sólo un ejemplo de un cambio que se está produciendo en cada vez más puestos de trabajo.

Inteligencia Artificial y Creadores Individuales

DEVAR lanzó MyWebAR en 2021 como herramienta de autoría sin código para experiencias WebAR. En la primavera de 2023, esa plataforma se hizo más potente con una red neuronal para la creación de objetos de Realidad Aumentada.

Al crear un activo 3D a partir de una indicación, la red determina el número de polígonos necesarios y replica la textura. El activo 3D resultante puede existir en experiencias de Realidad Aumentada y servir como marcador en sí mismo para experiencias de segunda capa.

“Un diseñador hoy es alguien que no sólo sabe dibujar, sino también describir. Hoy, es lo mismo en Realidad Extendida”, dijo a Metaverse News la fundadora y directora ejecutiva de DEVAR, Anna Belova. “Nuestro objetivo es poner esto al alcance de todos… sólo tienes que abrir tu imaginación”.

Desdibujando las líneas

“Desde el punto de vista estrictamente de la creación de un mundo, la IA asume gran parte del trabajo”, dijo a Metaverse News Grant Anderson, director ejecutivo de Mirrorscape. “Hacer todos estos modelos y entornos lleva mucho tiempo y dinero, así que la IA es una bala mágica”.

Mirroscape pretende “dar vida a tu juego de mesa con realidad aumentada 3D inmersiva”. Por supuesto, gran parte de la belleza de los juegos de mesa reside en el hecho de que los jugadores crean sus propios mundos y personajes sobre la marcha. Aunque el elemento de juego de rol ha sido reproducido por otras plataformas, Mirrorscape aporta la creatividad individual a través de la IA.

“Lo nuestro es el contenido creado por el usuario, y creo que al final la IA va a revolucionar todo esto”, afirma Grant. “Va a difuminar las líneas en torno a lo que es un editor de juegos”.

Incluso para quienes son constructores profesionales pero pueden ser independientes o estar empezando, la inteligencia artificial, ya sea para crear activos o simplemente para idear, puede ayudar a nivelar el terreno de juego. Ese fue uno de los temas del reciente taller de Zapworks “¿Puede la IA liberar tu potencial de creación? Aumentar la realidad con herramientas de IA”.

“La IA está dando ahora a individuos como yo y como todos vosotros una especie de superpoderes para competir con los colectivos”, dijo el director creativo ejecutivo de Zappar, Andre Assalino, durante el taller. “Si yo fuera una banda de un solo hombre, si estuviera empezando con mi pequeña empresa de diseño o lo que fuera, si sólo fuera yo por cuenta propia, ahora podré hacer mucho más de lo que podía hace cinco años”.

NeRFs

Los Campos de Resplandor Neuronales (NeRF) no se incluyeron en la introducción porque pueden considerarse una combinación de IA generativa y visión por ordenador. Empieza con un tipo especial de red neuronal llamada perceptrón multicapa (MLP). Una “red neuronal” es cualquier inteligencia artificial basada en el cerebro humano, y un MLP es… bueno, míralo de esta manera:

Si alguna vez has asistido a un curso de ingeniería, o incluso a una clase de taller en el instituto, te habrán presentado el dibujo. Los dibujos técnicos representan una estructura 3D como una serie de imágenes 2D, cada una de las cuales muestra diferentes ángulos de la estructura 3D. Con el tiempo, puedes llegar a visualizar bastante bien la estructura completa a partir de estas imágenes planas. Una MLP puede hacer lo mismo.

La diferencia es el resultado. Cuando lo hace un ser humano, el resultado es un pensamiento: una comprensión espacial del objeto en el ojo de tu mente. Cuando lo hace un MLP, el resultado es un NeRF, una representación 3D generada a partir de imágenes 2D.

Al principio, esto significaba introducir innumerables imágenes en el MLP. Sin embargo, en el verano de 2022, Apple y la Universidad de Columbia Británica desarrollaron una forma de hacerlo con un solo vídeo. Su enfoque estaba específicamente interesado en generar modelos 3D de personas a partir de videoclips para su uso en aplicaciones de Realidad Aumentada.

Tanto si un NeRF recrea a un ser humano como a un objeto, se está convirtiendo rápidamente en la forma más rápida y sencilla de hacer gemelos digitales. Por supuesto, el único inconveniente es que el NeRF sólo puede crear modelos digitales de cosas que ya existen en el mundo físico.

Gemelos digitales y simulación

Los gemelos digitales pueden construirse con o sin inteligencia artificial. Sin embargo, algunos casos de uso de los gemelos digitales están potenciados por la IA. Entre ellos se incluyen simulaciones como la optimización y la preparación para catástrofes. Por ejemplo, se puede crear un gemelo digital de un campus real, pero luego modificarlo en un ordenador para maximizar la producción o minimizar el riesgo en diferentes escenarios simulados.

“Puedes hacer cosas como escanear zonas de una refinería, pero luego crear versiones optimizadas de esa refinería… y tener diferentes simulaciones de las cosas que ocurren”, dijo Weili Dai, cofundadora y presidenta ejecutiva de MeetKai, a Metaverse News en una entrevista reciente.

Un conjunto reciente de herramientas de autoría lanzadas por la empresa (que empezó en la IA antes de ramificarse en las soluciones de Realidad Extendida) incluye herramientas potenciadas por la IA para crear entornos virtuales a partir del mundo virtual. Éstos pueden dejarse como gemelos digitales exactos, o pueden editarse para agilizar la producción de mundos virtuales más fantásticos proporcionando una base construida en la realidad.

Grandes modelos lingüísticos

Los Grandes Modelos Lingüísticos reciben indicaciones lingüísticas y devuelven respuestas lingüísticas. Esto forma parte de la lista de interacciones de la IA que se ejecutan en gran medida bajo el capó para que, idealmente, los usuarios no se den cuenta de que están interactuando con la IA. Por ejemplo, los grandes modelos lingüísticos podrían ser el futuro de las interacciones con los PNJ y los “agentes no humanos” que nos ayudan a navegar por vastos mundos virtuales.

“En estos entornos de mundos virtuales, la gente suele sentirse más cómoda hablando con agentes virtuales”, dijo el director general de Inworld AI, Ilya Gelfenbeyn, a Metaverse News en una entrevista reciente. “En muchos casos, actúan en algunas funciones de servicio y son preferibles [a los agentes humanos]”.

Inworld AI fabrica cerebros que pueden animar avatares de Ready Player Me en mundos virtuales. Los creadores deciden qué sabe la inteligencia artificial -o a qué información puede acceder desde la web- y cómo es su personalidad mientras camina y habla por el paisaje virtual.

“Básicamente, estás enseñando a un actor cómo debe comportarse”, dijo Kylan Gibbs, CPO de Inworld, a Metaverse News.

Los grandes modelos lingüísticos también son utilizados por los desarrolladores para acelerar los procesos de back-end, como la generación de código.

Cómo devuelve la Realidad Extendida

Hasta ahora hemos hablado de cómo la inteligencia artificial mejora las experiencias de Realidad Extendida. Sin embargo, lo contrario también es cierto, ya que la Realidad Extendida ayuda a fortalecer la IA para otros usos y aplicaciones.

IA en evolución

Ya hemos visto que algunos enfoques de la inteligencia artificial siguen el modelo del cerebro humano. Sabemos que el cerebro humano se desarrolló esencialmente por ensayo y error, a medida que se elevaba para satisfacer las necesidades de nuestros primeros antepasados. Entonces, ¿qué pasaría si los cerebros virtuales tuvieran la misma oportunidad?

La doctora Martine Rothblatt informa de esa misma oportunidad en el excelente libro “Virtually Human: The Promise – and the Peril – of Digital Immortality”:

“[Los académicos] han llegado a programar elementos de autonomía y empatía en los ordenadores. Incluso crean mundos artificiales de software en los que intentan imitar la selección natural. En estos mundos artificiales, las estructuras de software compiten por los recursos, sufren mutaciones y evolucionan. Los experimentadores tienen la esperanza de que la conciencia evolucione en su software como lo hizo en la biología, con una velocidad mucho mayor.”

Alimentar la IA

Como cualquier tecnología emergente, las expectativas de la gente sobre la inteligencia artificial pueden crecer más deprisa que las capacidades reales de la IA. La IA aprende cuando se le introducen datos. Muchos datos.

Para algunas aplicaciones, existen muchos datos de los que la inteligencia artificial puede aprender. Pero, a veces, las respuestas que la gente quiere de la IA no existen todavía como datos del mundo físico.

“Uno de los principales problemas del entrenamiento de la IA es la falta de datos”, dijo Finnur Pind, director general de Treble Technologies, a Metaverse News en una entrevista reciente.

Treble Technologies trabaja en la creación de sonido realista en entornos virtuales. Para entrenar a una inteligencia artificial a trabajar con sonido, necesita archivos de audio. Históricamente, éstos se muestreaban minuciosamente con diferentes cosas que causaban diferentes sonidos en diferentes entornos.

Normalmente, durante las primeras fases de diseño, un arquitecto o diseñador de automóviles se dirigirá a Treble para predecir cómo sonará el audio en un espacio futuro. Sin embargo, Treble también puede utilizar su software para generar sonidos específicos en entornos específicos para entrenar la inteligencia artificial sin todo el tiempo y el trabajo de muestreo. Pinur llama a esto “generación de datos sintéticos”.

La relación entre IA y Realidad Extendida es “y”, no “o”

Sostener que la inteligencia artificial es la nueva tecnología de la manzana que, de algún modo, le quita terreno a la Realidad Extendida es una narrativa interesante. Sin embargo, los expertos coinciden en que estas dos tecnologías emergentes se refuerzan mutuamente, no compiten. La RX ayuda a la IA a crecer de formas nuevas y fantásticas, mientras que la IA hace que las herramientas de la RX sean más potentes y accesibles. Hay espacio para ambas.